一、Robots功能:

用于约定允许,还是禁止搜索引擎抓取网站内容。

二、概念:

Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

三、通常具有以下作用:

(1)在robots中提供SiteMap(网站地图),为搜索引擎指路,方便搜索引擎抓取网页内容;

(2)屏蔽网站中一些不必要的网页,如:搜索结果页,帮助内容页等;

(3)屏蔽网站比较大的文件,如:视频、图片等,节省服务器带宽;

(4)屏蔽网站内的一些死链接,利于搜升搜索引擎排名提升。

说明(1)

一般网站都会提供网站地图,便于搜索引擎更好的理解网站的结构,以及理解网页的重要性关系,思途系统即提供了自动网站地图功能,自动存放在网站根目录下。

引导搜索引擎前往抓取的语句:

User-agent: *

Allow:/Sitemap.xml

(注:思途CMS系统提供sitemap生成工具,位置:站长工具 > Sitemap)

说明(2)

列表页,搜索页,往往是多条件组合出来的页面,排列组合下来,数量众多,重复度高;

网站底部的帮助栏目往往与网站目标关键词无关,从搜索算法角度来讲,建议禁止抓取为好。

禁止抓取语句示例:

User-Agent: *

Disallow: /*-* (备注:多条件列表页)

Disallow: /*?* (备注:搜索页面以及带?号的所有页面)

Disallow: /*help* (备注:底部帮助页面)

Disallow:/*servers* (备注:底部导航)

说明(3)

视频,图片等都很大,搜索引擎爬虫来抓取时,就会下载这些内容,搜索引擎数量重多,如:百度、google、360、搜狗等等。加上爬行频次高时,一天会来很多次,这样就会不断的请求下载服务器上的这些资源,占用服务器流量。有时会出现网站没有真实的用户访问,但服务器商统计的流量也会很高,往往就是这些原因导致的。

解决这个问题的方法,一般包括:

1、使用外部图片、视频服务器;(思途有提供三方服务器支持)

2、压缩图片(思途有提供图片压缩算法)、视频大小;

3、禁止搜索引擎抓取。

禁止抓取的语句:

禁止搜索引擎抓取以下格式图片语句:

User-Agent: *

Disallow: /*.jpg$

Disallow: /*.jpeg$

Disallow: /*.gif$

Disallow: /*.png$

Disallow: /*.bmp$

说明(4)

网站因为改版,原来的一些链接访问不了,或者错误填写了网址,这些都会带来错误链接,即死链接,搜索引擎抓取到这些页面,算法会认为网站的用户体验不好,经营者不够用心等,从而可能降低网站的关键排名,因此,利用思途后台死链生成功能,获取链接,通过站长平台进行死链提交,就有利于提升搜索引擎对网站的评价(排名)

禁止某错误网址被抓取语句:

User-Agent: *

Disallow: /http://www.xxx.com/aaa.html

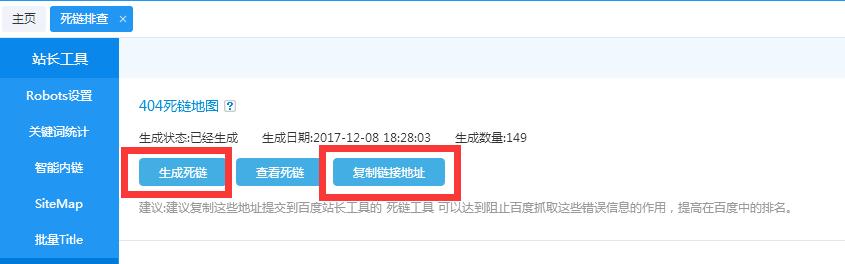

(注:思途CMS系统有提供404Sitemap,死链地图生成工具,位置:站长工具 > 死链排查。当死链页面数量比较多时,可以使用百度站长工具,提供的批量404页面提交功能。百度404页面提交禁止抓取的方法)

首先点击生成死链,生成后点击复制链接地址,到站长平台进行地址提交。

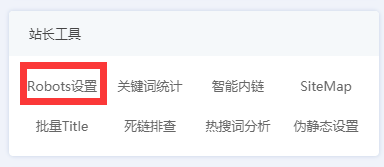

四、设置位置:

后台--站长工具--robots设置

更多帮助:

更多Robots的编写方法:

小米

小米

会员评论